知难不难,惶者生存。

作者 | DougLong

编辑 | 火柴Q、甲小姐

*本文为甲子光年专栏作家DougLong独家稿件。作者为AI从业者、Gary Marcus《Rebooting AI》一书中文版(9月上市)译者。开设知乎专栏《湿乎乎的数据智能》(文末点击“阅读原文”可访问此专栏)。

冬天已经不远了,我们在春天与夏天要念着冬天的问题。……这一场网络设备供应的冬天,也会像它热得人们不理解一样,冷得出奇。

——任正非《华为的冬天》,2000

2000年,华为前所未有地高速发展。依据上半年形势,华为在当年10月展开大规模校招,向2001届毕业生发放了一万个offer。

任正非在内部大会上说:“这些毕业生要为2001年销售400个亿、2002年销售600个亿做战略贮备”[1]。

华为当年在计算机电子通信等院系分宿舍宴请毕业生,劝签协议。

然而,同一时间,通信设备市场发生巨变,部分运营商开始在Q4砍掉年初的项目计划。

扩张招聘不久后,任正非开始反省,在2000年底写下了著名的《华为的冬天》一文。

公司所有员工是否考虑过,如果有一天,公司销售额下滑、利润下滑甚至会破产,我们怎么办?

如果华为公司真的危机到来了,是不是员工工资减一半,大家靠一点白菜、南瓜过日子,就能行?或者我们就裁掉一半人是否就能救公司?

如果是这样就行的话,危险就不危险了。

——任正非《华为的冬天》

来年2月,该文被登在华为内刊《管理优化》上,尽透任正非的矛盾与迷茫。

此时,危机已十分明显:2000年全年,华为收入下降39%,任正非经历两次癌症手术,并患上重度抑郁。来年Q1,华为销售额进一步降至30亿元人民币,全年销售收入225亿,比预期的400亿缩水近一半;实际报到的毕业生也从10000多减少至约6500名;而任正非的母亲也在这年因车祸离世。

任正非本人和华为公司都陷入了谷底。

华为和整个电信产业正经历着一场狂暴夏天后的严冬,而它的源头正是上一次技术红利带来的热潮:互联网泡沫。

2019年的今天,常被视为互联网之后下一代信息技术革命的AI行业也经历着相似的情景:

在2016年初AlphaGo奇观开启此后三年的资本追捧、估值竞赛和大众期待后,此时此刻,AI行业进入需要交出“落地答卷”的时刻。

而当资本累计在中国AI领域砸入2200多亿元人民币后,这场被假想40分钟就能搞定的考试过去大半,人们才发现卷面上仍是答案寥寥。

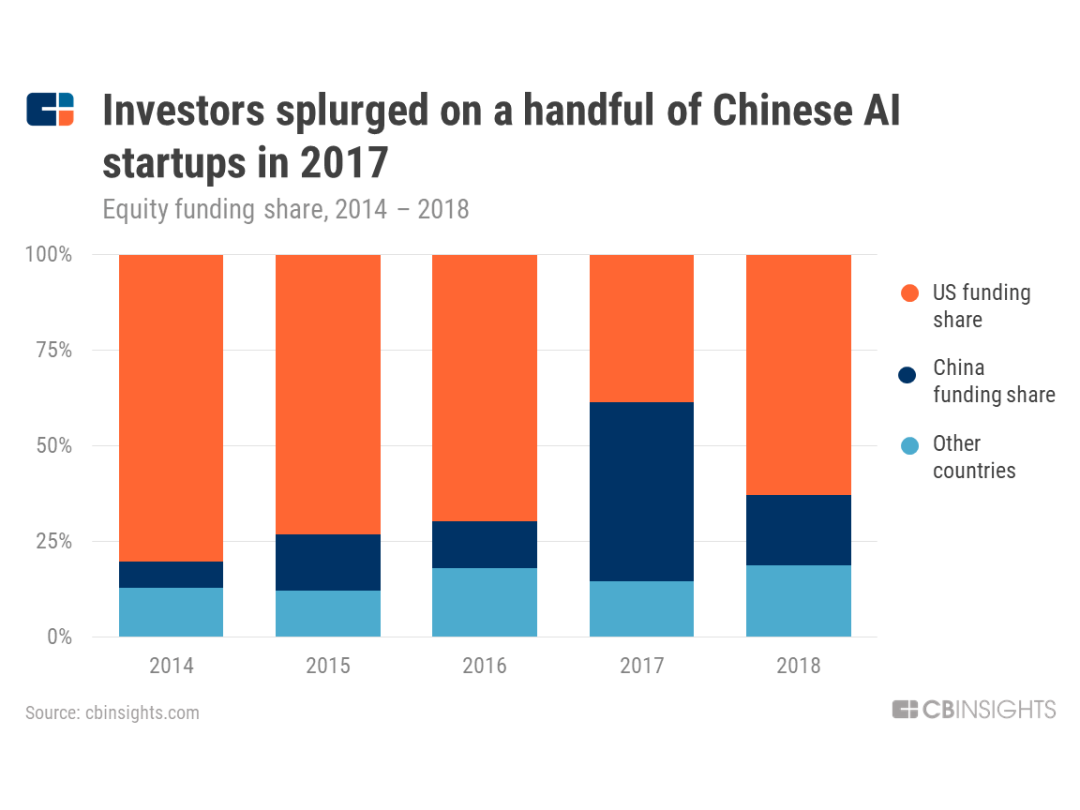

据CB Insights数据,中国AI领域初创公司融资金额在2017年猛增,占比首次超越美国,达到48%,位居世界第一。

细数先后引领热潮的AI细分赛道,如今在商业化上都面临不小的挑战。

计算机视觉头部玩家业务纷纷几经调整,仍未找到足以支撑估值的扎实商业化方向;据《华尔街日报》报道,去年软银愿景基金为商汤注入10亿美元资金时,甚至因估值太高,引起了中东LP之一,穆巴达拉发展公司的不满;

智能语音公司,嘴里是“新一代交互入口”,面前却是to B打行业的慢与难,和to C市场的巨头环伺与总量未起;

打脸最响的要数自动驾驶,遥想2016,多少公司许下豪言要在2019年交量产作业,但全行业都低估了这条路的挑战,这一集合了机械、工程、智能文明的巅峰领域如今成了AI最艰苦的赛道;

甚至一些曾经的明星公司已开始出现裁员、业务收缩、估值down round的现象。

据亿欧《2019年人工智能投资市场研究报告》,今年1-5月,中国一级市场AI行业投资总额163.4亿元人民币,目前只有去年全年投资额(1405.3亿人民币,不计蚂蚁金服)的11.6%;平均投资额2.1亿元/笔,较去年的4.2亿元/笔下跌50%。

“AI寒冬论”呼之欲出。

AI换季,考验有多严峻?历史上的寒冬可以为此时此刻带来哪些启示?

本文将从历史、技术、产业和资本等角度分四部分聊当下问题,有硬核技术,也有行业八卦,追溯原因,也看未来趋势:

1.泡沫筑起:华为之冬和互联网之夏

2.热潮再临:深度学习是AI银弹吗?

3.产业之痛:AI落地的三重落差

4.几度春秋:实事求是方能知难不难

太阳底下无新事。在上一个寒冬和这一个可能到来的寒冬期间,最大的危险都并非冬天本身,而是人们对冬天是否诚实。

以史为鉴,只有少数勇士,敢于直面惨淡的真实。他们戒除幻觉的麻药,承认问题,自省痛处,甚至断腕自救,才换来了九死后的涅槃重生。

1.泡沫筑起:华为之冬和互联网之夏

如果有CEO鼓吹用EBIDTA来估值,就把他绑起来做个测谎吧。

——沃伦·巴菲特

把华为带入冬天的这轮互联网泡沫(dot-com bubble)有三个阶段:泡沫形成期、泡沫破裂期、产业恢复期。

1996-2005互联网泡沫十年变迁(曲线底图来源:华尔街日报)

其实,在华为大肆招聘的半年前,泡沫破灭期到来的信号就已显现。

窸窣的碎裂声最早出现于2000年春。

当年2月,美联储开启新一轮加息。

3月,《巴伦周刊》发表文章“Burning Up”,预估207家互联网公司中的51家现金流即将枯竭,包括Amazon在内,几乎所有网络公司都撑不过12个月。

祸不单行,微软的垄断案也即将在3月中旬判决,如果监管要求这家科技巨头分拆,必然会导致其衰退。

多重消息叠加之下,市场最终轰然倒塌:

3月11日,刚在前一天冲上5048.62点历史高位的纳斯达克开始暴跌,到3月30日,纳斯达克股票总市值已在10日内超跌10%,从6.71万亿美元到达6.02万亿美元,当年4月6日又进一步跌到5.78万亿美元。

多米诺骨牌一个个倒下。

靠融资过日子的互联网公司没钱了,不得不削减设备采购和网络带宽需求;华为、北电等产业链上游的电信运营商和网络设备商订单锐减。

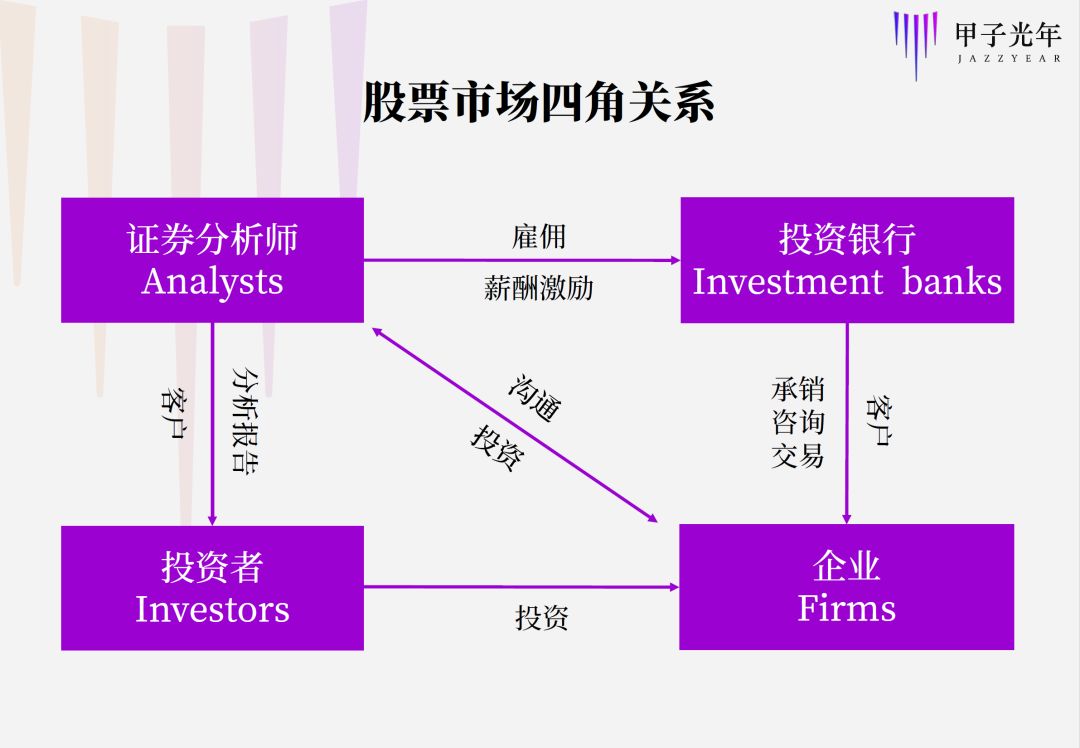

如图所示,箭头表示钱的流向。此前,在互联网泡沫高筑,市场信心膨胀时,所有箭头上的钱都依次增加;而现在,大厦已倾,所有箭头上的钱都跟着变少甚至清零。

而已上市的运营商和设备商还面临着资本市场的重挫。

如北电、朗讯、思科等都在自身股价较高时,通过贷款、发债等方式拿到了巨款,花起钱来十分激进:

北电2000年以80亿美元收购互联网公司Alteon Websystem,泡沫破裂后几乎一文不值;

北电、思科、朗讯竞相向新兴网络公司和小型运营商提供高额的贷款购买计划,后来全成了坏账。

随着北电等公司自己的股价也开始大幅下跌,不但再难用股权借新钱,连老债主也更急迫地讨还欠款,因为之前质押的股权已资不抵债。

不幸中的万幸是,作为不上市、不拿VC投资的网络设备商,华为只受到了订单减少的影响,风险并未被资本市场放大。

这场泡沫,使华为写下“冬天”;北电大减值、大裁员;全球2000多家互联网公司倒闭;硅谷在2001年到2004年初减少了20万份工作……可谓惨烈。

在美国如此成熟的证券监管和估值体系中,泡沫当初是被怎么吹起来的?网络公司的估值为何如此脆弱?

一个重要原因是:重利之下,华尔街不仅自己罔顾事实,还误导了整个市场。

起初,这种对事实的“修饰”无伤大雅,是人类面对新事物时,天真与冒险精神的综合产物。

故事得从大胆锐意的摩根士丹利分析师玛丽·米克尔(Mary Meeker)讲起,她之所以能赢得“互联网女皇”的地位,在于她为互联网建立了一系列全新估值法。

在1995年给Netscape做IPO时,米克尔先是创造了“终值贴现估值法”(discounted terminal valuation):以5年后的预估利润和增长率估算现在的价值。

Netscape成了第一个不挣钱却能在上市第一天股价就暴涨的公司,纳斯达克的互联网时代随之开启。

之后,一大批像Netscape这样没多少资产、不盈利甚至还不知如何盈利的公司进入二级市场,上市公司越发早期化,传统的P/E、P/B估值法难以为继,连终身贴现估值法都力有不逮,米克尔于是开始越来越多地使用非财务指标:

在1998年针对Yahoo的报告中,她将独立用户(Eyeball)、浏览量(Page View)跟估值挂钩:

“4000万独立眼球以及浏览时间和数量的增长,这个价值应该比Yahoo现有的100亿美元市值更高才对。”

在分析Drugstore和HomeStore时,米克尔又提出了Engaged Shopper(浏览超过3分钟的用户)和Mind Share(在同类网站中占据用户浏览时长的比例)两个指标。

这些新指标,看似符合互联网商业逻辑:用户量和使用时长越高,未来可能获得的收入也越高;如果市场占有率领先,就有机会统治细分领域,待条件成熟时大规模收割。

以电商网站为例,看互联网公司从用户到收入的转化链条

但如上图所示,图中越靠右的指标的财务相关性越大,越接近公司能否盈利的真相。米克尔却有意无意地忽略了这一点,主要采用靠左的指标,因为这些数字更漂亮。

按道理,如果图中打问号的转化链条还不成熟,说明公司的商业逻辑尚不清晰,应该继续拿VC的钱,而不是上市。

但在热情高涨、信心四溢的泡沫形成期,米克尔这套大胆的做法显然更受欢迎。与其把对非财务指标的滥用视为“扭曲事实”,更多人相信这是“合理想象”。

摩根士丹利的另一位分析师Steve Galbraith后来感慨道:在网络泡沫中,证券市场的投资者实际干了风险投资的事儿。

最炙手可热时,米克尔要同时参与30家公司的研究报告编写;准备上市的网络公司会向摩根士丹利点名米克尔,否则就不让大摩承销。

硅谷的创业者会关注她的行程,猜测她搭哪一趟航班,好制造偶遇机会。

《华尔街日报》将她与格林斯潘、巴菲特并列为最有影响力的市场推手。

据说1996年,时任英特尔总裁的安迪·格鲁夫正是在夏威夷度假时看了米克尔300页的“互联网报告”后醍醐灌顶,做出了英特尔也要大力拥抱互联网的决定。

米克尔之所以受追捧,是因为互联网实在太新了,无旧规可蹈,所有人都需要一个新锐、有力的权威来告诉自己怎么办,也需要给自己的激进找一个名正言顺的理由。

但互联网给市场带来的这种推陈出新的冒险风格,却触发了不好的风气:脱离盈利实际的估值倾向开始向非互联网领域蔓延,代表行业就是作为互联网上游的网络运营商。

发展到这步,华尔街与事实的背离,已不是“修饰”程度了。

以美国本地运营商Winstar为例,这本是一家有成熟商业模式的公司:以投资换收入,买设备建立并运营网络,再向用户收取网络服务费。

但在泡沫期,Winstar获得了来自微软和顶级PE Welsh、Carson等的大量资本。疯狂扩张之下,盈利是不可能盈利了,没法儿按P/E(股价除以收益,不盈利时是负的)估值,又要上市,那怎么办?

华尔街总有办法,他们把利润换成了另一个口径:EBITDA——税息折旧及摊销前利润。

EBITDA的妙处是,原本要在利润中扣除的投资并购资产、一次性购买的固定资产,在该算法下,会根据使用周期分N期折旧摊销后,不必从利润中扣除。

有EBITDA打掩护,Winstar玩起了一套神操作。

他们在2000年以1.45亿美元(其中现金是9500万)投资了一家B2B电商公司WAM!Net。该投资要求WAM!Net采购Winstar的网络带宽服务:先一次性支付2000万服务费,然后在后续7年中,再每季度递增支付500~2500万。

这相当于Winstar用9500万现金投资换来了2000万当期收入+7年约4.2亿的预估收入。

划重点:这9500万的资产折旧摊销在EBITDA里不算成本,但凭空涨了收入!

Winstar还跟一家光纤提供商Williams Communications达成了类似的“默契”:以每年不计入EBITDA的0.92亿的资产折旧摊销为代价,套来了每年1亿的收入。

Winstar跟客户的报表双赢,本质上就像这个GDP的笑话

这样玩下去,理论上收入可以想涨多少就涨多少,但真实亏损却越来越大,直至大厦崩塌。

难怪巴菲特会说:“如果有CEO鼓吹用EBIDTA来估值,就把他绑起来做个测谎吧。“

这样简单的数字游戏,难道老练的分析师和投资者看不出来?

利令智昏,EBIDTA虽渣,挡不住赚钱。

当时研究过Winstar的分析师曾说:“EBITDA唯一的好处,就是可以帮华尔街促成更多交易。”“分析师总希望推动下一单成交,因此他们会有意无意地蒙上自己的眼睛。”

更有甚者,不仅蒙自己的眼,还要迷他人的眼。

2000年10月20日,美林证券前首席网络投资分析师布洛杰特在内部电子邮件中称InfoSpace是垃圾股,但他却并未向投资者发出警告,反而积极推荐买入。对韭当割,人生几何。

在事后反思中,美国SEC(相当于中国证监会)认为,在网络泡沫中频繁出现的分析师不顾投资者利益的行为,源头是Chinese Wall(投行承销业务和证券分析师之间的防火墙)的倒塌。

在投行、分析师、企业和投资者的四角关系中,原本的规矩是:分析师只为投资人负责,而不能跟企业有利益关系,也不能牵涉到投行面向企业的服务,否则研究报告就会失去中立性,造成投资者损失。

这有点像媒体规范中的“采编、经营分离”:分析师的角色类似记者,职责是监督市场;而投行服务业务则类似广告等媒体经营活动,目的是通过服务客户来赚钱。

但在泡沫期,这套隔离制度不再有效。

比如米克尔女皇就私下把Netscape叫作“My baby”。她认为自己帮着搞上市的公司就要负责到底,不能说太多负面。

部分投行甚至进一步在激励制度上推了一把:使分析师的薪酬里含进了投行企业服务的收益,有些分析师还会个人投资企业。证券分析与企业服务,以前有利益冲突,现在却形成了“协同增效”。

股票涨时,这种协同看起来没什么不妥,分析师、企业、投资者皆大欢喜。可下跌一旦开启,击鼓传花就玩不下去了。

此后,虽然美国证券业提出“分析师薪酬要与投行交易经纪业务脱钩”,“严格限制分析师的个人投资交易”等规定,但这些措施恐怕难以解决问题。证券研究报告如果坚持内容付费的商业模式,投资者的“打赏”并不足以支撑高水平分析师的投入——灰度永远存在。

层楼误“精英”,自由乱行业。泡沫循环上演,无非因为:每当信心水涨,利益船高,聪明人会犯蠢,整个机制会产生打破规则的冲动。

一次又一次,人们并非不能发现真实已被过度美化,但整个市场却拒绝面对寡淡的素颜。

2.热潮再临:深度学习是AI的银弹吗?

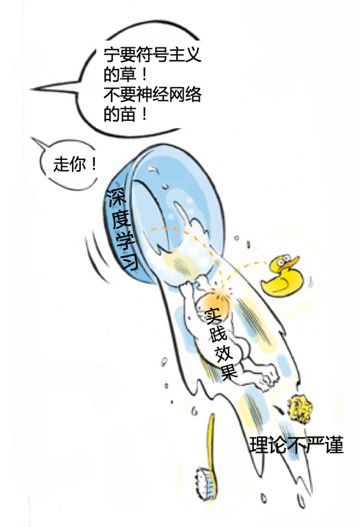

深度学习也落入了“寻找银弹”(银弹在欧洲民间传说中是吸血鬼和狼人克星,引申义为致命武器、杀手锏)的陷阱,用充满“残差项”和“损失函数”等术语的全新数学方法来分析世界,依然局限于“奖励最大化”的角度,而不去思考,若想获得对世界的“深度理解”,整个体系中还需要引入哪些东西。

——Gary Marcus, 《Rebooting AI》,2019

2016年之后,新一轮技术浪潮AI进入大热阶段,一样的天真畅想、一样的乐观预计、一样的大胆冒险,一样的泡沫初现。

与上一轮被资本推起的互联网热潮稍有差异,这一次,AI大热以深度学习在学界的戏剧性翻身为先声,以工业界的重视为重要推力,最后以AlphaGo大胜李世乭为爆点,用奇观效应带动了资本热情和大众期待。

在科技智库「甲子光年」以往的文章《科创板,一瓶AI的卸妆水?》中总结了这波AI浪潮不同阶段的估值公式。我们可以此为线,来看过高的期望是如何累积的。

Phase-1:2012-2016

Value = f(算法,人才)

早在1986年,Geoffrey Hinton就发表了“Learning Representations by Back-Propagating Errors”,改进了诞生于70年代的神经网络反向传播BP算法。1989年,法国人Yann LeCun又在贝尔实验室开始用卷积神经网络识别手写数字。

但直到约1/4世纪后的2012年,深度学习才在日后崛起的大数据和大算力加持下,证明了其在超大规模数据集上的超强图像分类能力。

以Google为首的工业界第一时间看到了这项进展,Google花5000万美元买了Hinton和他学生的部分时间,仔细思考深度学习如何开启下一代信息技术革命。

当时,AI已在圈内引爆,但尚未被大众广泛认知,创业公司还没有产品甚至没有demo,估值主要看技术奖项、科学家名气和团队博士数量。此类公司的特点非常鲜明,绵延至今。

能源行业的一位资深咨询顾问老Z说:“(2019年)5月我去中石油搞的一个行业论坛,CV四小龙之一的某公司上台做报告,PPT前5页都是创始团队哪哪儿牛校毕业、赢过什么国际大赛、平台有什么先进算法、技术指标百分之多少……这率那率的,过了十多分钟才进入正题,一共就20分钟的讲话啊。这气质,在这论坛里真是独一份。”

Phase2:2016-2018

V=f(算法,人才,市梦率↑,行业地位↑)

随着2016年AlphaGo横空出世,吸引眼球,全社会对AI颠覆世界的期望被迅速推高。

看到AI下棋赢了,就以为机器人很快会抢走人类工作;看到一个demo跑得不错,就以为能用在企业实际生产中;看到一个客户案例,就以为能快速复制到整个行业。

想象中的价值空间无限大,因为全行业、全人类的市值都可以算成AI产业的基数,市梦率由此上升。

这样美丽的“误会”,不仅发生在大众、媒体、资本和客户身上,也让部分身在此山中的AI从业者过于乐观——毕竟故事说了太多自己也信了。

Phase 3:2018至今

V=f(算法↓,人才↓,市场空间↑,数据↑,行业地位↑)

V平台=f(合作伙伴/开发者数量,调用次数,调用均价,数据量)

V应用=f(市场空间,客户数,客单价/单次调用价格,年订单总额,复购率)

V= V平台+ V应用

由于2018年资本市场萎缩,钱少了,更现实了,看市梦率的自然少了,市场逐渐回归价值。

但价值如何衡量?软件行业的常规指标是P/E(看利润)或P/S(看销售收入);AI公司多数尚未盈利,或利润不稳定,所以只能用P/S。

这一阶段,许多AI公司的P/S是好几十倍,大大高出二级市场平均P/S——根据中信证券前瞻团队首席分析师英博的文章,美股软件板块市值10~30亿、30~100亿、100亿美元以上的公司,P/S分别为3.8、6.8和7.6倍,SaaS云计算的平均P/S也才10.7倍。

这就尴尬了,那只能再想办法做高收入,把P/S降到合理区间,才能让资本继续买单。

AI做收入,一靠努力,二靠财技。自己创过业、做过VC、现在混FA的小L说:“你说的dot-com时代的那个Winstar,老外那点手段算什么?……(此处省略1000字)”

乱象已现,这一场欢愉也到了盛宴将息,从头反思,沉心做事之时。

在2018年的Gartner技术成熟度曲线中,此轮AI的代表性技术——深度学习正处于“期望膨胀(也可说是泡沫)”的顶峰,往后的期望值会加速跌落至幻觉破灭的谷底,再随着商业成熟缓慢回升。

但已入宴就坐的各方显然不愿这么快扫兴,事实再次被拒绝看见。

各行各业仍在想办法贴上AI标签,只要挂上羊头就能拿到更高估值或补贴,反正AI也没有严格定义。

看到企业为AI科学家和工程师开出高价,不少学生竞相转型,各种AI培训班应运而生。

AI甚至成了政客的一张好牌:

特朗普在贸易战背景下签署行政令,倡议美国要保持AI领导地位,美国国防部立马给出AI发展策略,后续自然少不了DARPA(美国国防高级研究计划局)的大手笔资金。

而且这一次,不光现任总统关心AI,连未来总统候选人也打出AI牌。

将在明年竞选总统、曾在2000年干过dot-com创业的民主党华裔候选人Andrew Yang,把AI作为他竞选纲领中的重要武器,声称AI等新技术会消除三分之一的人类工作,因此要给每人每月1000美元的全民基本收入(UBI)。

在《华尔街日报》的采访中,Yang预测AI会跨过技术低谷期,直接走向产业成熟期:“AI即将走出实验室的炒作阶段,真正变成有用的产品,这将影响数百万的工作岗位。”

就冲着Andrew,美国媒体在AI话题上暂时也不会熄火了吧。

然而,热潮之下,一个事关此轮AI变革成败关键的原动力似乎到了必须再讨论的时候——深度学习。

深度学习足以成为撑起未来AI世界的坚硬基石吗?

2017年底,AI界顶级大会NIPS上,Test of Time论文奖项获得者Ali Rahimi在掌声中登场。讲完获奖论文后,Rahimi在大屏幕上放出了出人意料的一页:Alchemy,炼金术。

炼金术起于中世纪,是当代化学的雏形。其目标是将一些其他金属转变为黄金,制造万灵药和长生不老药。直到19世纪之前,炼金术一直未被科学证伪。包括艾萨克·牛顿在内的一些著名科学家都曾尝试过炼金术。

——维基百科

“炼金术”,绝对是人工智能行业的敏感词了。

要知道,早在50多年前,正是著名智库RAND公司赞助的论文《炼金术和人工智能》(Alchemy and Artificial Intelligence)引发了AI的第一次冬天。

Rahimi在这场演讲中尖锐地将近来快速发展的机器学习(主要指深度学习)比作炼金术:虽然效果不错,但缺乏严谨、完备、可验证的理论知识,连业内人士都不理解自己做的东西是怎么运转的。

Boris发给Rahimi的邮件,抱怨TensorFlow一个参数调整带来不可预知的问题。

例如,不小心修改一个参数就会带来模型效果的天翻地覆;极简两层线性网络中遇到的问题,在增加网络复杂度之后就奇怪地消失了……但没人能说清为什么。

再例如,业界都知道,批量归一化可以降低ICS(Internal Covariant Shift,内部协变量偏移)从而加快模型训练速度;但是,似乎没人知道为什么降低ICS就能加速训练,也没有证据证明批量归一化就一定能降低ICS,甚至整个业界都缺乏对ICS的严格定义。

Rahimi说,自己虽然不懂飞机原理,但不怕坐飞机,因为他知道有一大批飞机专家掌握了原理。而深度学习最让人担心的是,他知道其他人也不知道。[11]

By Randall Munroe,xkcd

Rahimi的演讲在AI社群中引起了不少共鸣,以至于惊动了深度学习界大佬Yann LeCun。

从80年代起就经历过多年AI路线之争的LeCun似乎嗅到了意识形态攻击的危险,他立刻回应道[13]:

神经网络确实没法在理论上证明自己一定收敛,但我们在实践中效果很好。因噎废食很危险!当年正是因为这种批判态度,让神经网络被AI社群抛弃超过十年之久,绝不能让历史重演!

LeCun如此激动地捍卫深度学习,可能是争怕了。自AI诞生以来的60多年,路线之争就没停过。在2010年之前的大部分时间里,联结主义(推崇深度学习和神经网络)一直被符号主义(推崇专家系统)打压。

Rahimi演讲中的一句话“我怀念十年前NIPS上对理论严谨性吹毛求疵的学术警察”,一定会让LeCun老人家回忆起AI界由于意识形态“迫害”带来的1995-2007年浩劫:

这期间,坚持深度学习研究的LeCun和Hinton、Bengio等人组成了加拿大CIFAR小团体,但论文被各种顶会拒绝,拿不到经费和算力资源,更招不到好学生。

现在,终于熬出头的LeCun、Hinton、Bengio三位大佬在2019年携手捧得图灵奖。可居然有人怀念NIPS学术警察,将深度学习比作炼金术?

在LeCun这次激动回应之前,他还刚刚在同年10月与Gary Marcus进行了一场严肃辩论。后者是纽约大学符号主义老一辈代表人物Steven Pinker在MIT的学生、纽约大学心理学与神经科学教授[15]。

2017 NYU AI辩论会,左Marcus右LeCun(网友弹幕不代表本文观点)

辩论中,Marcus试探性地说:要不要在算法中预置一些先天知识,就像人类一样?

他认为虽然深度学习在感知和某种程度的语言翻译上做得不错,但深度学习的向量无法映射人脑的计算过程,不能完全处理抽象推理和决策。

而LeCun却认为深度学习已在模式识别上证明了自己,未来也可以做好抽象推理;甚至深度学习可以帮我们理解人脑的思考机制。

LeCun认为,先天预置知识应该能少用就少用,能不用就不用。当下AI应该沿着深度学习路线革新学习范式——做到在无监督情况下学习世界的模型,形成知识结构,就像人类司机不需要自己开车撞树,也能预测出如果撞树会发生什么。

LeCun并非只有态度,他也提出了一种具体的深度学习新范式——自监督学习:构建更巨大的网络,让机器观看现实世界中的海量视频,根据已播放内容预测尚未播放的内容,从而学习关于世界的知识——更多的知识结构会是这个新方法的结果,而不是原因或驱动力。

机器看视频、尝试预测,就能学习关于世界的知识

从辩论可以看出,LeCun坚信自己找到了“AI银弹”:坚定走纯粹的深度神经网络路线,优化升级新的自监督学习范式,训练更海量的数据,就能让AI在图像、语音识别领域的成功复制到更多领域。

辩论最终在祥和氛围中结束,没有裁判,没有定论。

深度学习到底是不是AI银弹?以及AI领域真有银弹吗?

第三方DeepMind其后发声,指出了LeCun方法中的一个关键问题:

这种强调先天预置知识最小化的方法有个前提——“数据和算力可廉价获得”。

这也是导致此轮AI浪潮可能由夏转冬的“罪魁祸首”之一:

当AI走出象牙塔,来到产业前线,数据是脏的,现实是复杂的,又有多少商业场景符合LeCun的前提假设呢?

3.产业之痛:AI落地的三重落差

在传统的软件工程中,针对模块的单元测试、端到端的系统测试都非常重要,但在机器学习的项目中,面对不断变化的数据环境,这些测试不足以证明系统是否会按预设运行。于是,现场对系统行为的监控就尤为关键了。

——Google论文《Machine Learning: The High-Interest Credit Card of Technical Debt》

经过前几轮PK洗礼,Gary Marcus在他2019年的新书《Rebooting AI》中,将深度学习的问题重新归纳为3点:

1.对数据的极度贪婪和依赖;

2.运行机制和模型的不透明;

3.脆弱性,错误不可控。

这三点缺陷导致了想象中的AI与真实落地的AI之间形成了几重落差。

Gap 1:(想象的)大数据VS(现实的)小数据、脏数据、假数据、违规数据、孤岛数据

在数据行业摸爬滚打多年、最近转行到AI创业公司的数据分析师“小J”颇有感悟:

“这些年,媒体和各行各业言必称大数据,客户看到自己数据库存了多少TB甚至PB了,就以为自己有大数据;问客户某某数据有没有,客户满口说有。等实际入场后才发现,数据根本不可用,有些字段错得离谱,有些字段又太稀疏,等你做完清理后,剩下的数据可能跑个逻辑回归都够呛,根本没法上深度学习。

有些数据需要手工生成,质量也不可靠。有一次做浙江某轮胎厂的故障检测项目,故障样本是工厂每月被客户退回来的问题轮胎,几百上千个在露天的空场上堆成小山,落满了灰,只好雇人爬上去把灰擦一擦看清楚型号批次,再把信息和故障记下来。大热天的,又脏又累,后来就有人学会了偷懒,假造数据。

还有数据孤岛,比如A、B企业的数据维度都比较单一,但可以互补,需要放到一起才有价值,而A和B出于监管考虑又不能交换数据。一些大企业内部也有数据孤岛,实质是部门竞争、不愿配合,非要闹到大老板那儿去。即使老板拍板下来要打通,也有各种手段让你的效果大打折扣,脱敏、二次加工、延时等等。

数据来源有时打打擦边球也是公开的秘密了。在一些信息安全措施不那么严格的行业,找内部人员用硬盘拷数据是最经济有效的。几乎所有公司都在用爬虫,前不久有公司刚被抓,爬简历上的个人隐私牟利,算是行业反面教材了。”

Gap 2:AI训练测试数据VS实际运行环境数据

Facebook的LE?ON BOTTOU在ICML大会的演讲“Two big challenges in machine learning”中指出,机器学习给软件工程带来了新的混乱,原因是生产环境下,数据必然变化,使AI模型或算法无法按预期输出稳定结果。

机器学习模型软件模块的合约举例

如果把训练好的模型作为软件模块来集成,模块的输出受输入数据分布变化的影响,不能按模块之间的合约(contract)“办事”,造成其他模块无法正常工作。

更难受的是,何时、何种情况下会“违约”,无法预先界定。所以当系统给AI软件模块一个任务时,它能不能完成,能完成到什么程度,没准。

这就好比一个公司告诉你,在我司测试环境下,行人检测模型准确率为99.99999%;但在您的实际驾驶环境中,预计准确率在97%~99%之间,且我司既不确保准确率有多少,也无法判断何时准确率会异常。这车您还敢开吗?

弱合约在自动驾驶这种高鲁棒要求的场景下会对用户及产业造成伤害。

如果把训练算法作为软件模块来集成呢?也有新问题。

训练算法的输出依赖训练数据,而生产环境中的数据受太多因素干扰:隐藏的信息反馈循环、未声明的调用模块,都会让数据相互影响,不可控、不好追查。此外,在给真实客户做AI项目时,不同项目、项目不同阶段,都会带来不同的数据,从而影响算法网络结构设计和模型参数设定。

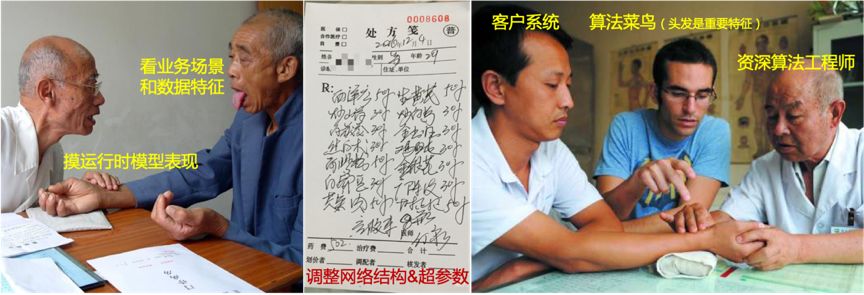

有多年工程及算法经验、待过互联网大厂也做过to B项目的“老P”说:

“做AI项目,客户第一次会给一小撮数据样本让你理解业务数据,等你入场做PoC(Proof of Concept,可行性验证)时会拿到批量的真实历史数据,等项目上生产环境你会碰到更实时的数据,等运行一段时间后又必然会遇到各种新情况,例如客户的用户定位调整了、政策有变导致业务环境变了等等。

这四个不同阶段,你所认知的客户数据的特点和分布都会变,而变化就意味着可能要重调超参数,重设网络结构,甚至重新取舍算法……折腾啊,但没办法,这就是做AI项目的命。”

更要命的是,这是长期的“折腾”;是时间、地点、人物不定的折腾;得去客户现场折腾,而不能远程云折腾;得派很贵的、掌握炼金经验和调参玄学的算法工程师去折腾,而不能让普通软件工程师去折腾。

这就引出了AI落地时的第三个落差,也是最现实的挑战:

Gap 3:AI to B项目对高级算法人才长期驻场的强需求VS此类人才的驻场成本和意愿

为什么to B项目通常都要驻场?

现阶段,大中型企业才有足够的数据、业务场景和钱做AI,而大公司对数据又有超强保护意识,数据不出门、不落地。要碰数据可以,请到客户现场来,有时还要求用客户提供的电脑干活。

为什么要长期驻场?

典型的AI to B项目有以下几个流程:

1.初步理解客户业务场景和需求;

2.初步调研客户数据情况;

3.可行性判断和初步方案设计;

4.深度理解客户业务,细化或调整AI算法目标和达到目标的路径;

5.深度理解客户数据构成、语义、质量和分布等细节,细化或调整算法方案和模型结构;

6.数据清洗和特征工程;

7.部署测试环境,训练并调参模型(效果不好的话要回到步骤4、5、6进行优化);

8.生产环境部署上线,调试生产bug(如数据泄露);

9.持续监控生产环境输入输出数据变化,并随时回到步骤4、5、6。

这里的4、5、6、7、8、9必须在客户现场完成,1、2可远程完成但也需要与客户交互,只有步骤3完全不涉及客户环境。

先说步骤4、5、6、7、8,短则两三月,长则大半年,跟客户配合程度有关,跟数据质量有关,跟问题复杂度、成熟度有关。更重要的,跟炼金运气有关。

最头疼的是9,前面的步骤即使周期再长,也有结束的一天,但步骤9(生产环境监控优化)却永无宁日,因为业务环境和数据变化是不可避免的,而算法模型不一定能自动适应到最佳状态。

为什么要高级算法人才长期驻场?

正如Rahimi所说,深度学习的理论不完备,算法模型的运行机制不可知,因此,各种调试优化能不能成功,靠的是经验加运气,能力难以快速复制。

这就像学中医一样,初级医师要成长为高级人才,需要做过很多项目,遇过很多情况,成功、失败经验都丰富的老中医手把手带,靠项目和悟性不断积累“望闻问切”的经验。

然而,行业的另一面现实却是,想让高级算法工程师长期驻场,太难了。

首先,驻场意味着人员很难复用,没法一人同时干N个项目,薪资成本是个问题。

其次,搞技术的通常不喜欢驻场,尤其是有经验的高级人才,一般岁数不小、有家有娃,长期出差有困难。

最后,公司里许多高级算法人才可能是在基础研究或底层架构部门,项目工程团队未必请得动。

BAT某云行业销售负责人“阿K”,一度对AI项目满怀憧憬,但后来宁可去卖CDN:

“我们今年中了一个千万级的标,其中的AI模块很关键。中标之后项目组都很兴奋,但是要干活时,麻烦了。

客户很看重数据信息安全,对外部驻场人员管得很严,每天上班要指纹打卡,封闭会议室办公,桌面必须保持清洁,否则罚款甚至通报批评。

客户给的IT支持比较少,我们工程师都说,驻场的SDE(Software Develope Engineer)其实是Someone Do Everything,跟在自家公司时比,驻场干的事太杂了,还没有延续性,不利于他们的技术发展。

现场跟客户沟通遇到些技术分歧时,人家好歹是甲方,我不提醒吧,有些工程师能让客户下不来台;我说他两句吧,人就说驻场要看客户脸色,不想干了。

结果这项目还没做到一半,比较资深的两个AI工程师就回去了,只好换了几个毕业没多久的顶着,项目进展很慢,客户很不爽。别给我搞烂尾了,哎。”

BAT另一朵云的行业售前总监、最近绞尽脑汁往自己行业里集成AI元素的“老W”说:

“有一次客户让我们做AI项目PoC,要比较高级的人驻场。我好说歹说,找AI研究部门借了几个人,出差去客户那儿干了一个半月,结果项目没成。以后再找,他们就再也不搭理了。

人家本来就不爱参与客户项目,又发不了paper,这么贵的人工成本花出去,又不一定能成为年终绩效上的业绩。”

驻场需求强烈,且得不到高效满足,是AI公司无法做到真正产品化(从业务运营角度的产品化)的重要原因。困于客户项目的PoC、交付和维护,脱身无门,也就无法大规模扩张。

吴恩达曾说:“如果普通人能在不到一秒的时间内完成某项脑力工作,那么我们很可能可以在现在或不远的将来用AI将其自动化。”

或许更符合事实的情况是这样:

如果普通人能在不到一秒的时间内完成某项脑力工作,那么我们很可能可以在现在或不远的将来用AI将其自动化,如果不行,至少可以找到一个符合条件的客户,把我们最贵的算法科学家砸进去,做一个demo出来。

4.几度寒暑:实事求是方能知难不难

在上一次的互联网寒冬之中,并非只有坏事。

2000年dot-com泡沫的破灭,并不是互联网技术的崩盘,而是“人人都要做dot-com”的崩盘。

两年后,在冬天生存下来的Google,以贴近底部的成本雇来大批互联网工程师,并以搜索商业上的突破,成功定义了互联网技术曲线的“产业恢复期”,顺便让米克尔女皇“被黑”的某些理论得到了平反。

也正是在互联网泡沫引发的电信危机中,华为涅槃重生。

任正非的思想历经沉淀、转变,再次清晰了两条价值观:

一是心态上,时刻准备着接受危机,知难不难,惶者生存。

在2000年底的《华为的冬天》中,他写道:“不经过挫折,就不知道如何走向正确道路。磨难是一笔财富,而我们没有经过磨难,这是我们最大的弱点。”

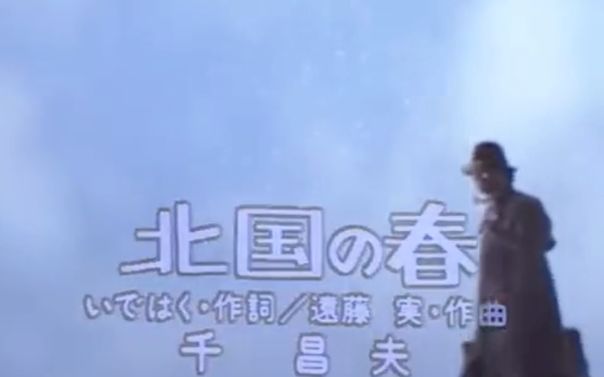

第二年,在探访了熬过10年低增长、负增长漫长寒冬的日本企业后,任正非写下《北国之春》:

什么叫成功?是像日本那些企业那样,经九死一生还能好好地活着,这才是真正的成功。华为没有成功,只是在成长。

华为经过的太平时间太长了,在和平时期升的官太多了,这也许会构成我们的灾难。泰坦尼克号也是在一片欢呼声中出的海。

创业难,守成难,知难不难。高科技企业以往的成功,往往是失败之母,在这瞬息万变的信息社会,唯有惶者才能生存。

《北国之春》描述的是创业者的奋斗故事,任正非说他曾数百次听这首歌,时常热泪盈眶。

知难不难,这是不怕直视自身弱点,也要接近真相的赤诚。

二是做法上,直面事实、自我批判。

当时的任正非一条一条梳理现实环境、华为的问题和应对策略,反复传导的核心做法就是要甩掉面子思维,敢于自我批判。

在2000年研发部门大会的演讲《为什么要自我批判》中,任正非说:

我们是为面子而走向失败,走向死亡,还是丢掉面子,丢掉错误,迎头赶上呢?要活下去,就只有超越,要超越,首先必须超越自我;超越的必要条件,是及时去除一切错误。去除一切错误,首先就要敢于自我批判。

承认“不行”,是自我批判的开端;务实,是冬天里的美德。

务实的华为,后来在2001年控制住了人员规模,卖掉安圣电气,趁泡沫破裂,朗讯、北电等撤出光传输领域之机,啃巨头扔下的骨头,从低端光传输逐步做到中高端,并同时在3G、4G通信设备研发及标准引领上建立“绝活”,逐步成为全球最顶尖的通信设备商。

2018年,华为成为首个销售额突破1000亿美元的中国企业,而且是高科技的ICT企业。

诚如华为在上一次寒冬中学到的经验:成就总和危机相伴而来,华为已成为如今贸易摩擦中的“重点狙击对象”;但也是对保持危机感和务实应对的多年贯彻,华为早早准备了震撼业界的“备胎计划”。

著名经济学家吴敬琏曾请任正非用一句话概括华为的成功,任正非说了四个字——“实事求是”。

再看如今泡沫气息初现的AI热潮,期望值已经上来,而落地又不尽人意,AI产业该如何延缓甚至避免冬天的到来?

实事求是地拆解一下,我们可以把入冬可能性(P)用以下公式表示:

P(winter is coming) = f(gap) = difference(expectation, reality)

所以,要么降低期望(expectation),要么提升现实价值(reality)。

降低期望,是主动认错好过被动挨打。

但这里有一个问题:大环境可以给务实、认怂的美德更多机会吗?

当年华为是没上市、也没有外部融资的公司,可以少顾及资本的看法。而互联网热潮开启风投模式后,如今的大多数新兴科技公司都多少受资本裹挟。

高台已上,旗已立,款已打,再打脸,就不只是面子问题。

那就只能老老实实提升现实价值。

务实地来看,整个行业能做的无非如下:

一是学界的继续突破,在产业应用中打破弱AI的局限性。

李飞飞和LeCun已分头辞去Google Cloud AI负责人和Facebook FAIR主管职务,更多回归研究。

李飞飞专注于AI可解释性,LeCun则坚持做下一代深度学习——“看视频学知识”的自监督预测学习,这种方法不需要大量人工标注数据,而是从数据中自动提取弱标注,同时预测出剩余标注,这部分解决了数据稀缺的问题。

LeCun主打的自监督预测学习对世界的模拟

朝通用AI目标前进的还有Gary Marcus等人推崇的、在深度学习中加入更多先天预置知识或结构(structures)的做法。

例如DeepMind和Google等机构联合提出的图网络(GNN:Graph Neural Network)——用深度学习对知识图谱进行操作,并获得新知识,其中的知识图谱,部分是专家预置(input)的,部分是学习出来(output)的。(关于“神经网络+符号推理”的更多方法,见“Neural-Symbolic Learning and Reasoning:A Survey and Interpretation”。)

但基础研究所需时间和成功概率极不可控,就连乐天派LeCun也坦承目前进展较慢,估计要“2年?5年?10年?20年?”。

所以第二条路,是在AI产品化和商业化上下功夫,这是行业越冬绕不开的路径。

着手点是直面上文提到的三重落差,将现实困境条分缕析,一一应对。

Gap1:大数据VS小数据、脏数据、假数据、违规数据、孤岛数据

解决小数据,靠行业信息化,而且是带着数据意识的信息化。

解决脏数据、假数据,靠堆人,而且是往客户现场堆大量的人。

解决孤岛数据,靠企业之间利益交换,或政府发文。

此外,Google最早提出、近期AAAI Fellow杨强教授力推的联邦学习,也是一种折中的解决办法(不换数据换模型,舍部分精度,保数据隐私)。

Gap 2:AI训练测试数据VS实际运行环境数据

数据落差的现实不可改变,必须要自动适应新数据,这也是机器学习出现的初衷。解决或缓解问题的办法只能从科研和工程上突破。

Google论文“Machine Learning:The High-Interest Credit Card of Technical Debt”中指出了几种解决方案,并倡议学术界和工业界把更多科研力量投入到这些AI技术债务上来,虽然看起来没有新算法、新模型那么性感闪亮,但更有益于AI长期健康发展。

Facebook的LE?ON BOTTOU则给出了更具体的建议:AI论文的审稿人应要求论文给出算法的局限性,例如,算法适应哪些数据分布,不适应哪些情况,“强迫”所有人关注算法模型的实际应用场景,共同提高AI在工程中的可用性。

近期大火的AutoML则是不同的思路,通过自动化选择模型和调参,虽然降低了人的参与度,但也造了一个更大的黑盒,进一步削弱了对神经网络内部的理解。

Gap 3:AI to B项目对高级算法人才长期驻场的强需求VS此类人才驻场成本和意愿

一是降低驻场需求和驻场成本,这和解决Gap 2的思路相似,需要借助AI科研和工程化成果,打造更标准的AI软件工程,形成低门槛的可复制“套路”。

二是提升驻场意愿,除了激励机制外,没什么讨巧的方法。就如同2001年互联网泡沫崩溃后,华为决意all in国际化战略,当时的高级副总裁徐直军说:“干部分为三类,第一类是全世界所有地方任由公司安排,第二类是国内所有区域任由公司安排,第三类是只愿去在国内经济发达地区。我们将第一类干部作为公司优先考虑提拔的人选。”

三是在AI to B的最后一公里培育数据算法系统集成商。AI公司自建交付服务团队的组织成本太高,需根据自家平台特性和规范,打造模板化、低门槛的方法和流程,帮助合作伙伴多快好省的建设数据算法调试实施能力。

逐步解决关于数据、工程和人的三大Gap,才能实现许多AI公司CEO讲给投资人、媒体及自己的故事:

先在标杆项目上做出效果,再形成产品的规模化复制,且不光功能可复制,交付、服务也可复制。

Life is tough, AI is challenging.

不过最可怕的从来不是难本身,而是不知道,不承认。知难反而不难。

鲁迅说,真的勇士,敢于直面惨淡的人生。

多事之秋,送诸君十二字共勉:丢掉幻想,好好干活,扎实过冬。

2019-08-06 21:02:25

2019-08-06 21:02:25