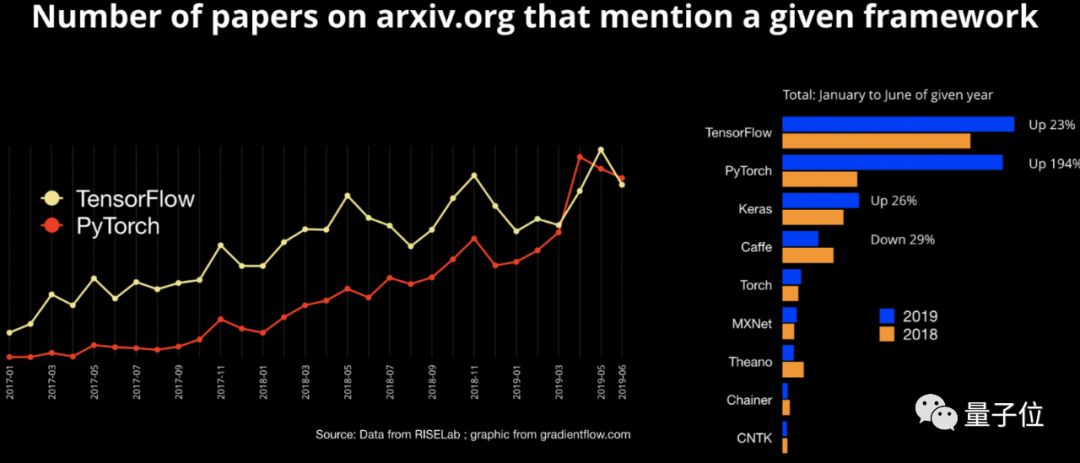

看样子,PyTorch超过TensorFlow指日可待了。

这个结论,来自于这样的数据:

2019年1月到6月底,在arXiv.org上发表的论文中,提及TensorFlow和PyTorch的数量相差无几,PyTorch仅稍稍落后。

但最关键的在于增长速度:与2018年1月到6月相比,PyTorch增长了194%。相比之下,TensorFlow的增长幅度仅为23%。

一方面有足够的基数,另一方面又有足够的增速,PyTorch已经具备超过TensorFlow的可能性。

数据来自于RISELab——隶属于加州大学伯克利分校的研究机构,目标是研发下一代大数据计算系统。

公布出来之后立即引发网友热议。

与之前不同的是,这次不是“PyTorch真香”现场,主题变成了吐槽TensorFlow。

吐槽TensorFlow现场在Reddit上的机器学习板块,这一话题已经有了200热度,获得80条评论。

其中排名第一的评论就是:

TensorFlow一直让人头疼,所以很高兴看到这么快就采用PyTorch。

到底如何头疼?也有不少网友给出了解释:

Tensorflow 1.0兼容性差

名为“bunny113”的网友评论称:

从GitHub repo中获取的Tensorflow 1.0代码,在其他版本上不起作用。

所以,我现在只用PyTorch。我喜欢它的动态性,而不是Tensorflow的静态性。

不断变化令人头疼

关于TF,让我头疼的一件事是不断变化。最初你必须从头构建模型,然后出现了TF.estimator (TF.layers) API,现在TF.keras将成为TF 2.0(以及将 TF.layers 标记为 legacy)中的标准。

也有网友有更加深刻的体会:

TensorFlow现在绝对是一场灾难。微小的版本增量,就会在我的代码中触发几十个弃用警告。

此外,还有其他各种各样的问题,比如TensorFlow很难调试、掌握门槛高等等等等。

吐槽现场链接:

https://www.reddit.com/r/MachineLearning/comments/chx7bq/d_one_simple_graphic_researchers_love_pytorch_and/

Tensorflow的优势之处尽管有那么多人吐槽,也并不意味着TensorFlow没优点,PyTorch非常完美。

需要注意的是的,这一数据来源是arXiv.org提交的预印版论文,群体几乎全是研究人员。

有网友发问:

研究人员也可能关心性能基准测试,有人关注在它们在硬件兼容性和优化,云支持(谷歌Colab)等方面的表现吗?

当然有,名为”muntoo“网友在评论区中表示:

我使用Tensorflow的主要原因,是Google提供了针对其他平台(例如Android)的集成。

确实,这是Tensorflow的优势,也是PyTorch需要改进的方面。

就在最近,TensorFlow还推出了一个新的图像分割教程,使用的是U-Net风格的架构(和一个预训练的MobileNet),链接地址:

https://www.tensorflow.org/beta/tutorials/images/segmentation

不过,Fast.ai创始人Jeremy Howard在Twitter上表示,因为深度学习是一个非常新的商业领域,业界与学界联系非常密切。PyTorch在研究人员中的使用大幅增长,也预示着今年会有越来越多的公司采用PyTorch。

你觉得呢?

作者系网易新闻·网易号“各有态度”签约作者

2019-08-06 09:10:41

2019-08-06 09:10:41