“始作俑者”是一款可以把人像变动漫的生成器。

只需一张图片或一段视频,无论男女老少、明星素人都可以一睹自己的“动漫风采”~

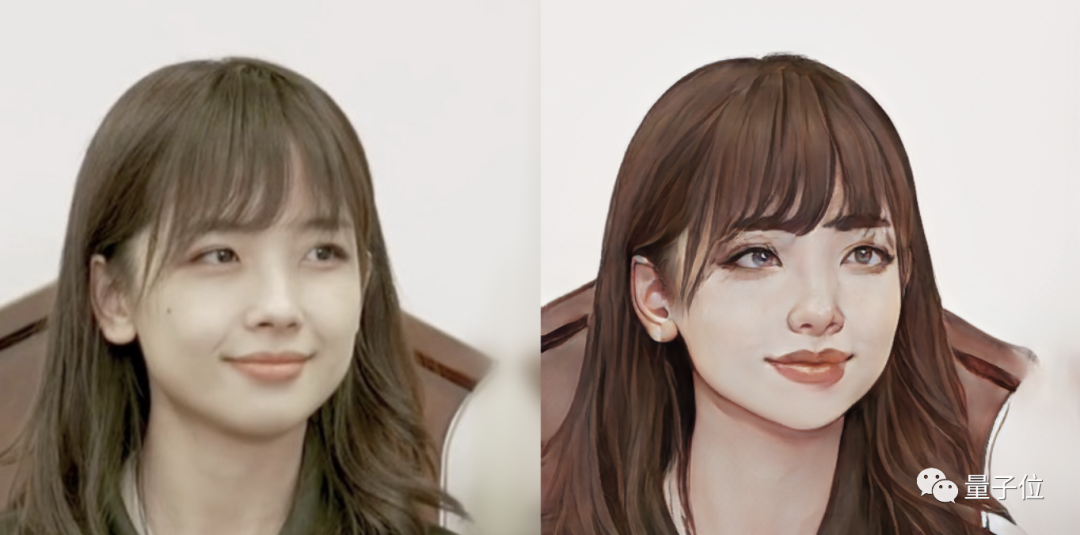

什么“国民老婆”王冰冰:

什么“国民妹妹”IU:

什么科技圈大佬、EDG 成员、金发美女、容嬷嬷……

发丝、眉宇,甚至眼神里流露出来的情绪,都给你“描绘”得淋漓尽致……

▲ 视频效果

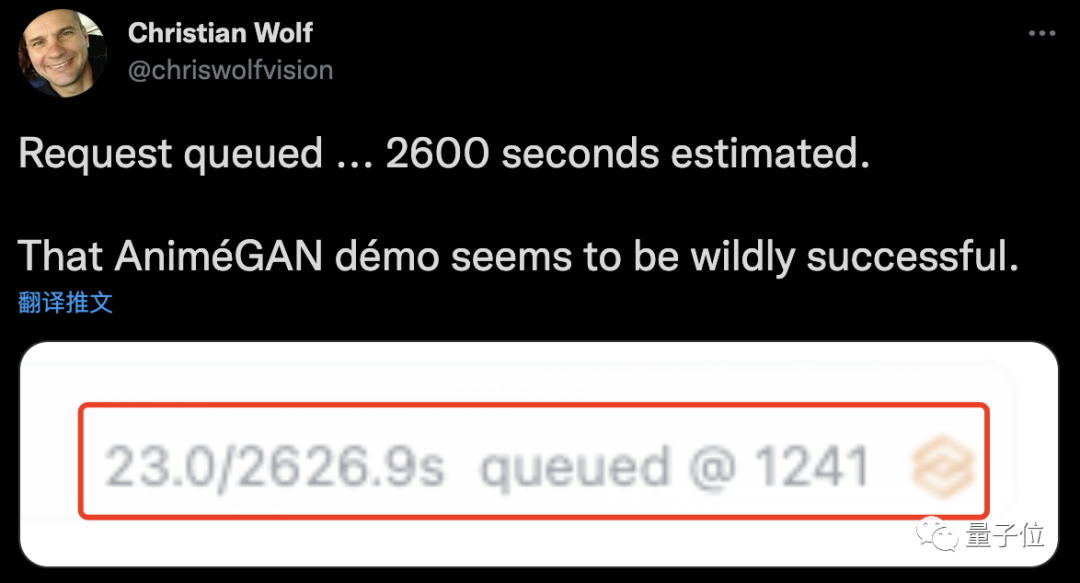

这也难怪网友把服务器都给挤爆了。

随便翻翻大家的作品,简直是深不见底。

再看看 GitHub 上的相关项目,果然也冲上了趋势榜第一名。

这个 AnimeGAN,真是厉害了!

如何给自己捏一个动漫脸?

看完展示的效果,你是不是也想打造一个自己专属的漫画脸了呢?

这个可以有,现在就手把手教你。

第一种方法就 very very 简单了,只需要上传一张照片就可以。

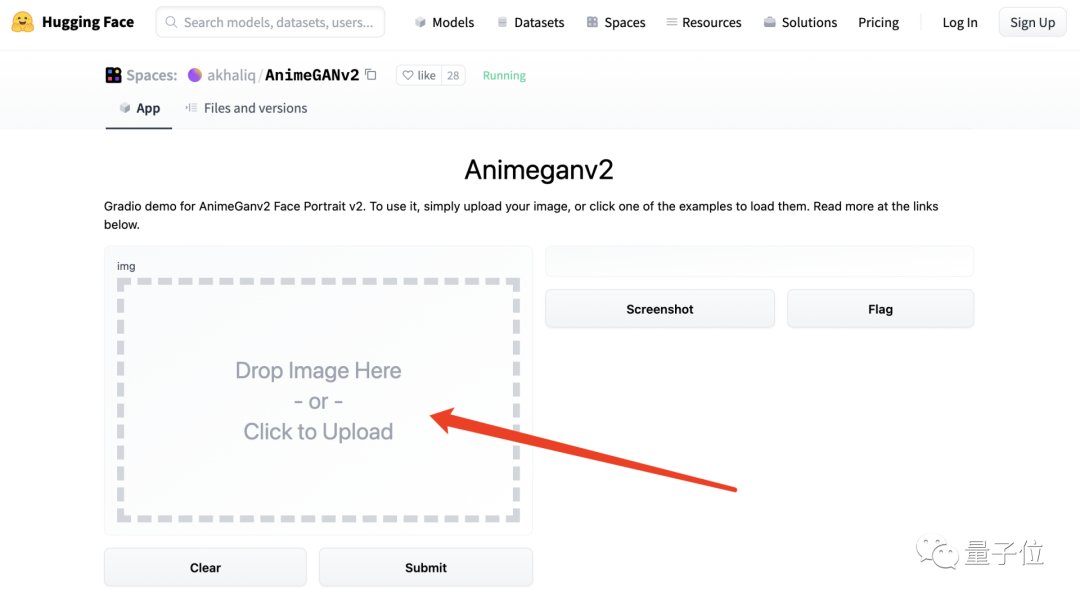

提供在线玩法的网站(链接见文末),就是那个著名的抱抱脸 (Hugging Face)。

它专门开设了一个在线 AnimeGANv2 的 App,直接把图片“丢”进去就好。

BUT!!!

也正如刚才提到的,现在这个 AI 着实有点太火了,简单的在线方法,就等同于排大队。

这不,等了 5259 秒之后,前面还有 15 人……

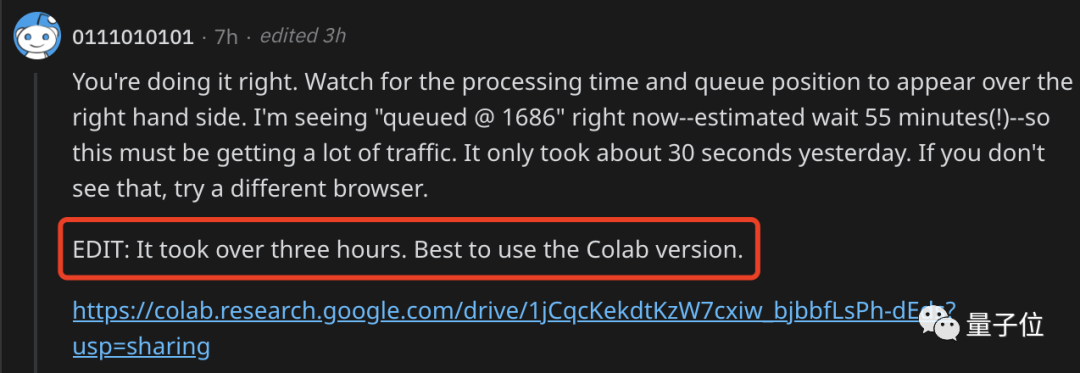

如果不想排队怎么办?

接下来,就是第二种方法了 —— 上代码!

热心网友在苦等了 3 小时之后,终于还是忍不住了,强烈安利 Colab 版本(链接见文末):

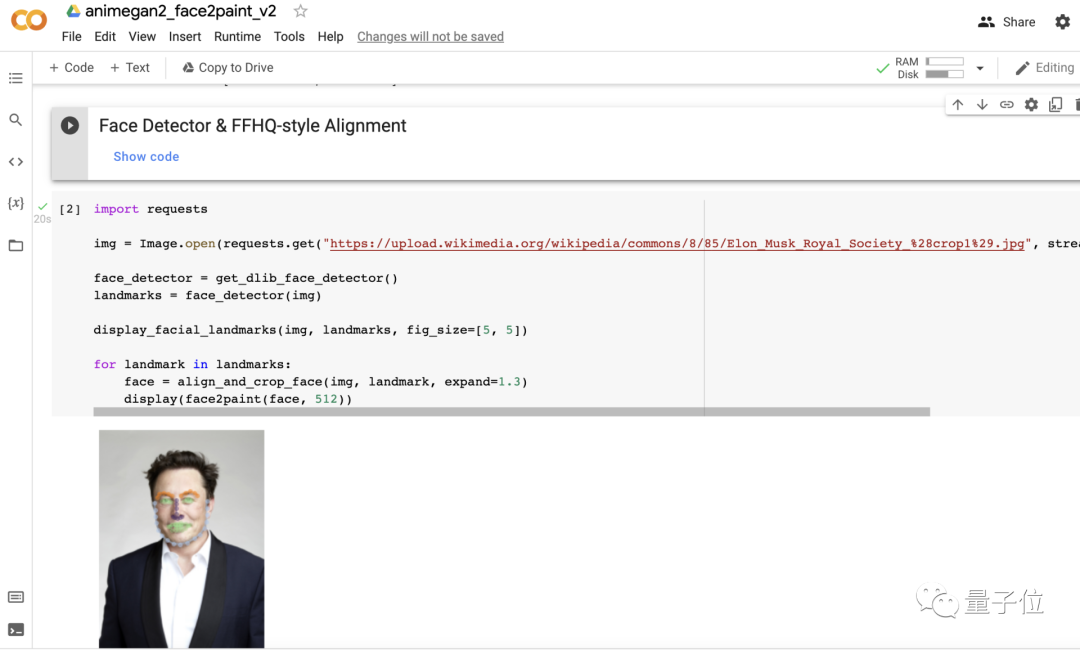

先运行一下文档里的前两段代码,然后只需要简单修改照片路径即可。

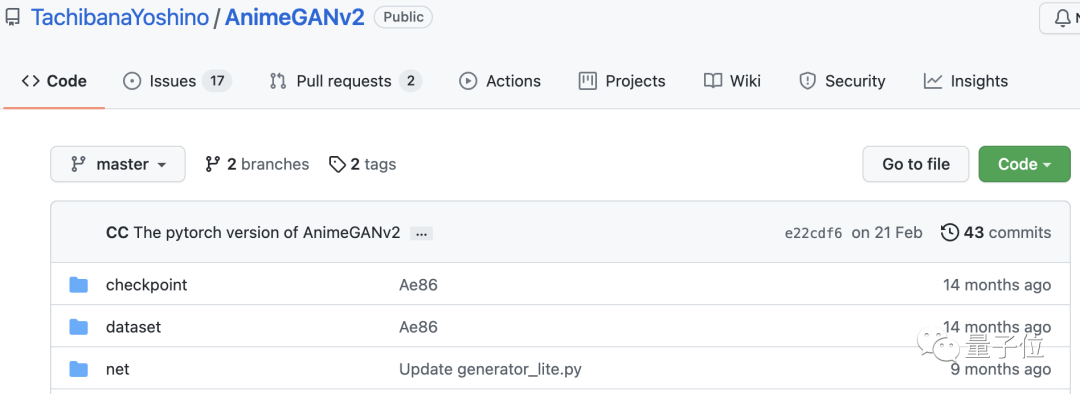

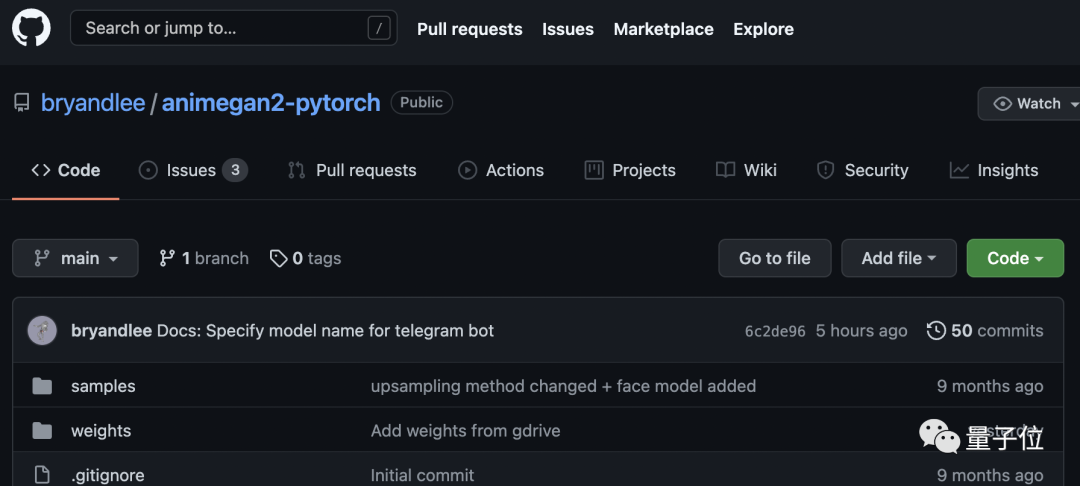

当然,如果想加大难度挑战一下,AnimeGANv2 的 GitHub 项目也是有的哈:

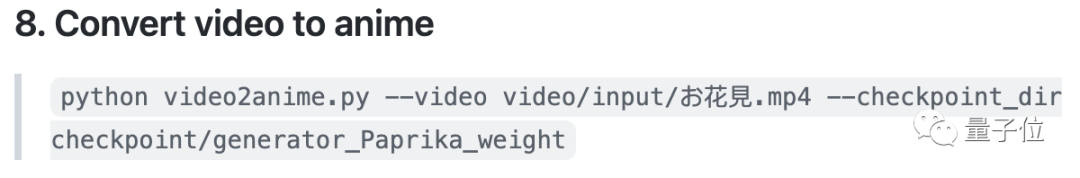

以上介绍的方法都是用图片转换,如果你想用视频的话,在 AnimeGANv2 项目中执行下面这两条命令就 OK:

当然,该项目的 Pytorch 实现也有,不过 Pytorch 版本目前只支持图片转换;如果想转视频,暂时就需要你自己写个脚本了~

风格迁移 + GAN

那么,如此效果的背后,到底是用了什么原理呢?

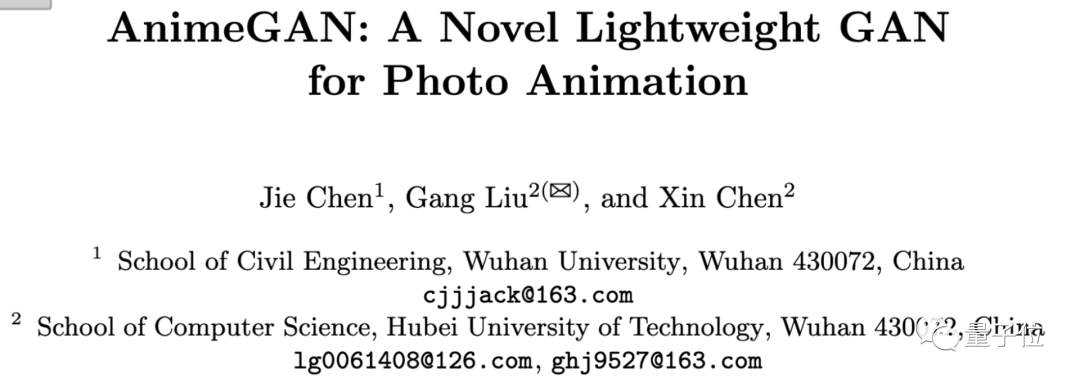

AnimeGAN 是来自武汉大学和湖北工业大学的一项研究,采用的是神经风格迁移 + 生成对抗网络(GAN)的组合。

它其实是基于 CartoonGAN 的改进,并提出了一个更加轻量级的生成器架构。

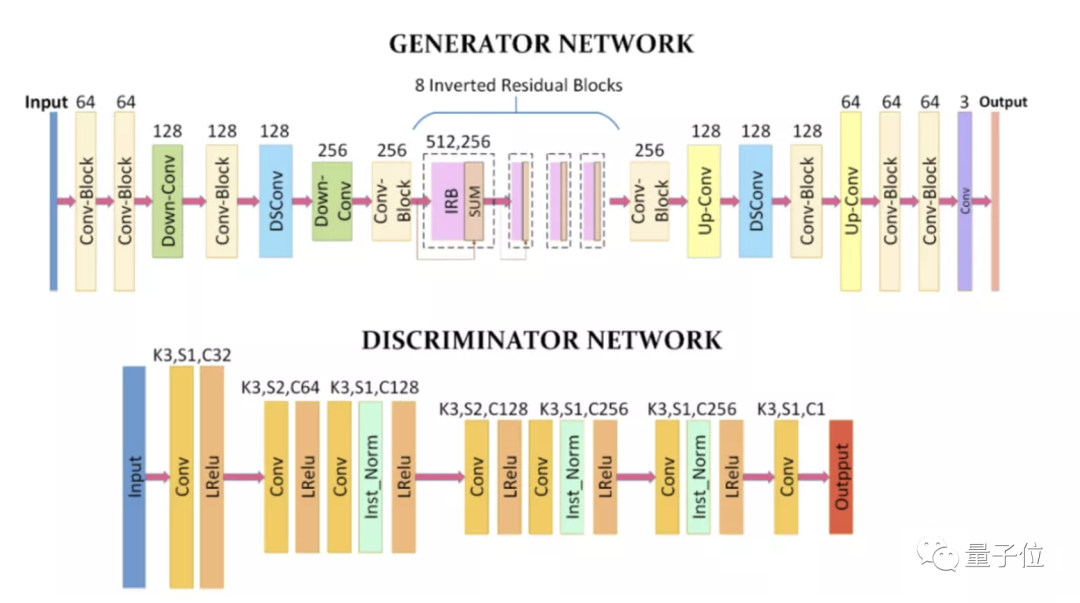

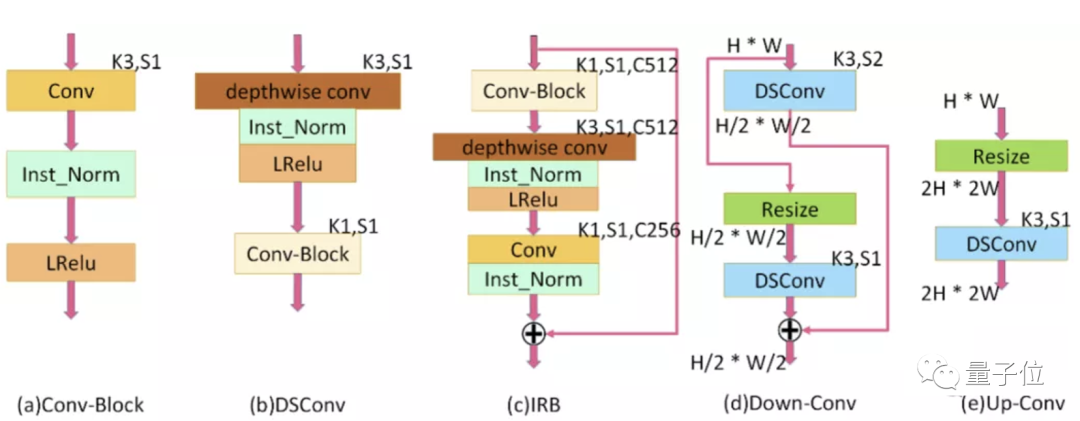

AnimeGAN 的生成器可以视作一个对称的编码器-解码器网络,由标准卷积、深度可分离卷积、反向残差块、上采样和下采样模块组成。

为了有效减少生成器的参数数量,AnimeGAN 的网络中使用了 8 个连续且相同的 IRB(inverted residual blocks)。

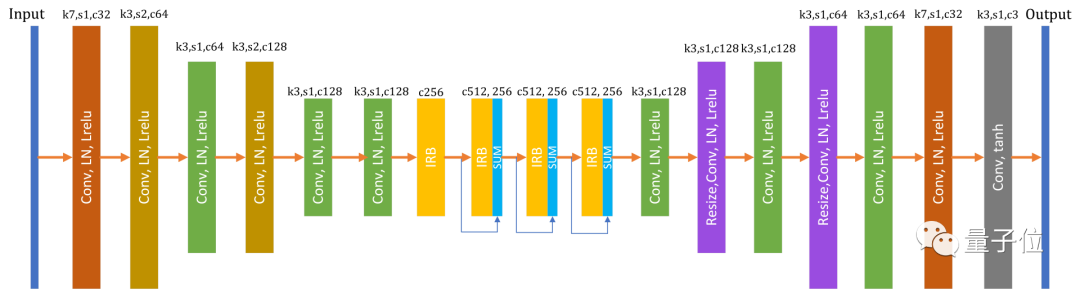

在生成器中,具有 1×1 卷积核的最后一个卷积层不使用归一化层,跟随其后的是 tanh 非线性激活函数。

上图中,K 为内核大小,C 为特征图数量,S 为每个卷积层的跨度,H 是特征图的高度,W 是特征图的宽度,Resize 值用于设置特征图大小的插值方法,⊕表示逐元素加法。

而此次的 V2 版本,是基于第一代 AnimeGAN 的升级,主要解决了模型生成的图像中存在高频伪影的问题。

具体而言,所采取的措施是使用特征的层归一化(layer normalization),来防止网络在生成的图像中产生高频伪影。

作者认为,层归一化可以使 feature map 中的不同通道,具有相同的特征属性分布,可以有效地防止局部噪声的产生。

AnimeGANv2 的生成器参数大小为 8.6MB,而 AnimeGAN 的生成器参数大小为 15.8MB。

它俩使用的鉴别器大致相同,区别在于 AnimeGANv2 使用的是层归一化,而不是实例归一化(instance normalization)。

网友:我变漂亮了

这个 AI 可算是圈了一众粉丝。

有些网友“冲进二次元”之后,发现了自己惊人的美貌:

它把我变漂亮了!

而且非常骄傲的晒出了自己的漫画脸。

还有网友看完比尔盖茨的效果之后,直呼:

天!盖茨看起来聪明又性感。

就连新海诚导演都曾转发过 AnimeGAN 的作品呢。

One More Thing

最后,大家上手之前一定要注意,虽然 AnimeGAN 展示的效果都是比较好的,但这有一个大前提:

照片一定要高清、五官尽量要清晰!

不然画风可能就会变得诡异(作者亲测,欲哭无泪)……

那么,你在漫画里是什么样子?

2021-11-21 14:46:11

2021-11-21 14:46:11